С каждым месяцем развитие ИИ выходит на новые, ранее неизведанные рубежи. Март не стал исключением и снова повысил планку достижений. OpenAI представила первые инструменты для создания автономных агентов, а Google DeepMind решила, что виртуальным ассистентам пора обзавестись руками физическими манипуляторами. Тем временем Anthropic выяснила, что LLM научились распознавать, когда их тестируют, и подгонять ответ под ожидания проверяющих (немного тревожно, не правда ли?). И это лишь вершина айсберга!

Разбираем главные события марта в ИИ: от моделей с контекстом в миллион токенов до китайских систем, которые достигают уровня GPT-4 по цене чашки кофе. По традиции также поделимся подборкой новых инструментов и исследований. Будет интересно!

Навигация

Свежие релизы

Обновления от OpenAI

OpenAI никогда не ограничивается одним-двумя релизами. Это всегда целый ворох новинок, причем одна интереснее другой. В марте они не стали сбавлять обороты.

Новые инструменты для создания агентов

OpenAI представила комплексное решение для разработки автономных ИИ-агентов. В центре релиза — новый Responses API, который объединил простоту Chat Completions API и возможности работы с инструментами из Assistants API. Вместе с ним разработчики получили три встроенных инструмента: web search (поиск в интернете), file search (поиск по документам) и computer use (управление компьютером).

Особенно интересен computer use — инструмент на базе той же модели Computer-Using Agent (CUA), что используется в Operator. На бенчмарке OSWorld для задач управления компьютером она показывает результат в 38,1%, а в веб-задачах достигает впечатляющих 87% на WebVoyager.

В дополнение к API компания выпустила open-source Agents SDK — улучшенную версию экспериментальной библиотеки Swarm. Фреймворк позволяет оркестрировать работу нескольких агентов, настраивать передачу управления между ними и отслеживать их действия. Например, Coinbase уже использует SDK для создания агентов, работающих с криптокошельками, а Box — для анализа корпоративных документов в сочетании с данными из интернета.

Новые аудиомодели GPT-4o: голос для ваших агентов

OpenAI представила три новые аудиомодели, которые выводят голосовое взаимодействие с ИИ на новый уровень. Две модели speech-to-text (GPT-4o-transcribe и GPT-4o-mini-transcribe) превосходят предыдущие решения в точности распознавания речи, особенно в сложных условиях — с акцентами, фоновым шумом и быстрой речью. А text-to-speech модель GPT-4o-mini-tts позволяет не только преобразовывать текст в речь, но и контролировать интонацию и стиль произношения.

Обновленный Agents SDK теперь поддерживает аудио, что позволяет разработчикам всего несколькими строками кода превратить текстового агента в полноценного голосового ассистента. Цены на новые модели достаточно демократичные: от 0,3 центов за минуту транскрибации до 1,5 центов за минуту синтеза речи.

Контрасты ценовой политики OpenAI

Похоже, в OpenAI решили покатать юзеров на эмоциональных качелях. Компания открыла API-доступ к o1-pro по цене, от которой у разработчиков глаза на лоб лезут: $150 за миллион входящих и $600 за миллион исходящих токенов. Для понимания масштаба: это в 4 раза дороже GPT-4.5 и в 274(!) раза дороже DeepSeek R1.

При этом SORA неожиданно стала самым доступным безлимитным видеогенератором на рынке: все ограничения сняты даже для подписчиков Plus за $20 в месяц. Для сравнения, ближайший конкурент Runway просит за аналогичную услугу $99.

Нативная генерация изображений с 4o: революция в картинках

OpenAI в своем репертуаре — пока все совершенствовали диффузионные модели, компания пошла своим путем и встроила генерацию изображений прямо в GPT-4o. Вместо привычной диффузии здесь используется авторегрессия. Модель не просто генерирует картинки — она понимает контекст, отлично работает с текстом (прощайте, кривые надписи!) и следует инструкциям с высокой точностью.

Особенно круто система справляется с задачами, которые раньше считались ахиллесовой пятой генеративных моделей: созданием технических иллюстраций, диаграмм и схем. А еще она может превращать программный код в изображения: например, если скормить модели код на Three.js, она выдаст готовую 3D-сцену.

Первые тесты показывают, что модель одинаково хорошо справляется как с художественными задачами, так и с сугубо практическими, вроде создания инфографики или технической документации.

OpenAI запускает бесплатную «Академию»

OpenAI решила, что пора не только создавать передовые ИИ-модели, но и учить людей ими пользоваться. Компания запустила OpenAI Academy — бесплатную образовательную платформу, которая претендует на роль главного учебника по работе с искусственным интеллектом (и нет, вам не придется продавать почку, чтобы получить доступ к курсам).

Программа выглядит впечатляюще: от базовых принципов работы с ChatGPT до продвинутой интеграции для разработчиков. Обучение будет проходить как онлайн через специальный хаб с учебными материалами, так и офлайн — через воркшопы и дискуссии.

Похоже, в OpenAI всерьез решили демократизировать доступ к знаниям об ИИ — что в наше время, пожалуй, не менее важно, чем доступ к самой технологии.

Учимся здесь.

А что у Anthropic?

Claude научился искать в интернете

Claude наконец-то научился гуглить! Anthropic добавила своему чат-боту возможность поиска по интернету — функцию, которой пользователи ждали, пожалуй, дольше всего. Пока веб-поиск доступен только для платных пользователей в США и работает исключительно с моделью Claude 3.7 Sonnet, но компания обещает расширить доступ.

Интересно, что Claude не просто ищет информацию, но и снабжает ответы прямыми цитатами из источников, как Perplexity, но на другом уровне. Однако ахтунг: галлюцинации все еще никуда не делись.

Инструмент «think»

Anthropic представила «think» — инструмент, который выделяет пространство для структурированного мышления во время решения сложных задач. В отличие от режима «extended thinking», анализирующего задачу перед генерацией ответа, «think» позволяет модели делать паузу и оценивать ситуацию прямо в процессе работы. На тестовом бенчмарке -bench такой подход показал впечатляющие результаты: в домене «авиаперелеты» accuracy выросла с 37% до 57%, а в ритейле достигла 81,2%.

Особенно эффективным оказалось сочетание инструмента с оптимизированными промптами, содержащими примеры рассуждений для конкретной предметной области. Словом, Anthropic нашла классный способ сделать свою модель не только умнее, но и рассудительнее.

Пачка новинок от Google

Gemma 3: мультимодальность для всех

Google выпустила третье поколение своей открытой модели Gemma, и тут есть чему удивиться. Модель получила поддержку мультимодальности (работает с изображениями и текстом), увеличенное контекстное окно до 128k токенов и понимание более 140 языков. Доступны четыре версии: от компактной 1B до мощной 27B параметров.

Особенно интересен процесс обучения: команда использовала комбинацию дистилляции, RLHF и даже обучение с подкреплением на основе исполнения кода (RLEF). В результате Gemma 3 стала лидером среди открытых компактных моделей в LMArena с впечатляющим счетом 1338. А учитывая, что предыдущие версии Gemma скачали более 100 миллионов раз, похоже, у сообщества разработчиков появится новый фаворит.

Google DeepMind: роботы учатся думать по-человечески

Google представила Gemini Robotics — новую модель на базе Gemini 2.0, которая переносит возможности ИИ из цифрового мира в физический. В отличие от предыдущих попыток, здесь мы видим действительно впечатляющий прогресс в трех ключевых направлениях: универсальность (модель справляется с незнакомыми задачами), интерактивность (понимает команды на естественном языке и адаптируется к изменениям) и, что особенно важно, ловкость в обращении с предметами.

Вместе с основной моделью компания выпустила Gemini Robotics-ER — специализированную версию с продвинутым пространственным мышлением. Она не только в два-три раза эффективнее базовой версии Gemini 2.0 в управлении роботами, но и может на лету генерировать код для новых действий. Например, увидев кружку, модель сама определит оптимальный захват и безопасную траекторию движения. В общем, кофе на ноутбук не прольет.

Обновление и без того крутых инструментов

Google представила сразу несколько впечатляющих обновлений для своих продуктов. В Gemini появился Canvas — интерактивное пространство для совместной работы над документами и кодом в реальном времени. Здесь можно не только создавать черновики текстов, но и сразу их редактировать, менять тон и формат. А для разработчиков Canvas предлагает возможность быстрого прототипирования: написали код, тут же увидели превью, внесли правки — и все это в одном окне (прощайте, десятки открытых вкладок!).

Еще одна интересная функция — Audio Overview, которая превращает ваши документы, презентации и исследования в обсуждения в формате подкастов. Представьте, что два AI-ведущих ведут живую дискуссию по материалам ваших файлов, выделяя главное и проводя неочевидные параллели. Особенно удобно для тех, кто любит учиться на ходу.

NotebookLM, инструмент Google для работы с документами и YouTube-роликами, тоже получил крутое обновление — генерацию интерактивных майнд-карт. Теперь одним нажатием кнопки можно превратить любой материал в древовидную структуру, по которой удобно перемещаться и «проваливаться» вглубь по интересующим темам.

Gemini 2.5 Pro: миллион токенов и первое место в рейтингах

Google DeepMind представила Gemini 2.5 Pro — модель, которая до сегодняшнего дня скрывалась в рейтингах под именем Nebula и уже успела наделать шуму. И есть чему удивляться: контекстное окно в миллион токенов (а скоро будет два!), мультимодальность из коробки и впечатляющие результаты на всех ключевых бенчмарках, где она обходит таких титанов как o3-mini, GPT-4.5, DeepSeek R1 и Claude 3.7 Sonnet.

Особый акцент Google сделала на способности модели к рассуждениям — не просто классификации и предсказаниям, а именно анализу информации и построению логических выводов. На тесте Humanity's Last Exam, созданном сотнями экспертов для оценки предела человеческих знаний и рассуждений, модель достигла 18,8% без использования дополнительных инструментов.

Модель уже доступна для тестирования в Google AI Studio и в приложении Gemini для пользователей подписки Advanced. В ближайшие недели она появится и в Vertex AI, где разработчики смогут использовать ее с повышенными лимитами для масштабных рабочих задач.

Google Colab получает ИИ-помощника для data science

Вышел Data Science Agent — ИИ-ассистент для работы с данными в Google Colab. Агент на базе Gemini автоматизирует рутинные задачи: от импорта библиотек до написания шаблонного кода. Достаточно загрузить данные и описать цель на естественном языке (например, «визуализировать тренды» или «построить модель предсказания»), и агент сгенерирует полноценный рабочий конструкт.

На бенчмарке DABStep агент уже занял четвертое место, обойдя решения на базе GPT 4.0, DeepSeek и Claude 3.5 Haiku. Пока инструмент доступен пользователям старше 18 лет в избранных странах, но Google обещает расширить географию в ближайшее время.

Sesame откройся: голосовой ассистент в открытом доступе

Возможно, вы уже болтали с нашумевшими голосовыми ассистентами — Майей и Майлзом. Стартап Sesame, разработавший их, выложил в открытый доступ свою базовую модель CSM-1B под лицензией Apache 2.0. Несмотря на скромные параметры (всего 1 миллиард), модель умеет генерировать RVQ-аудиокоды из текста и звука — ту же технологию используют Google в SoundStream и Meta в Encodec.

Компания планирует интегрировать Майю в AR-очки, превратив ассистента в постоянного спутника пользователя. Правда, есть и повод для беспокойства: хотя Sesame призывает разработчиков не использовать модель для имитации голосов без согласия и создания вредоносного контента, реальных механизмов защиты от такого применения пока нет.

Mistral: от работы с документами до мультимодальности

Mistral продолжает удивлять релизами в разных направлениях. Компания представила специализированный OCR API для работы с PDF-документами, который не просто конвертирует их в текст, но и умеет распознавать иллюстрации, фотографии и сложные элементы вроде математических формул. Особенность API — вывод в формате Markdown, что делает его идеальным инструментом для RAG-систем и работы с языковыми моделями.

Параллельно компания выпустила Mistral Small 3.1 — компактную мультимодальную модель, которая обходит аналоги вроде Gemma 3 и GPT-4o Mini по ключевым метрикам. При этом она достаточно легкая для запуска даже на одной RTX 4090 или Mac с 32GB RAM. Модель поддерживает контекст до 128k токенов и выдает впечатляющие 150 токенов в секунду. А главное — она выпущена под лицензией Apache 2.0, то есть полностью открыта для сообщества. Отличный вариант для локального деплоймента.

AMD врывается в гонку ИИ-моделей

AMD неожиданно присоединилась к соревнованию ИИ-гигантов, представив семейство языковых моделей Instella. Несмотря на скромные 3 миллиарда параметров, модели показывают впечатляющие результаты, превосходя открытые аналоги и конкурируя с такими тяжеловесами как Llama-3.2-3B, Gemma-2-2B и Qwen-2.5-3B.

Интересно, что AMD тренировала модели с нуля на своих GPU Instinct MI300X (128 штук, если быть точнее), обработав 4,15 триллиона токенов. Это серьезная заявка на место в сегменте ИИ-ускорителей, где долгое время доминировала NVIDIA. А самое приятное — все модели семейства Instella выпущены в открытый доступ, включая веса, конфигурации для обучения и даже датасеты.

Похоже, AMD решила конкурировать с NVIDIA не только в железе, но и в софте.

Новости из Китая

Китайская индустрия ИИ развивается с такой скоростью, что мы решили выделить под их достижения отдельный раздел. Рассказываем, что коллеги из Поднебесной представили в марте.

Alibaba: тройной удар по рынку ИИ

QwQ-32B: эффективность важнее размера

Alibaba выпустила QwQ-32B — новую reasoning-модель, которая буквально показывает, что размер — не главное. С «всего лишь» 32 миллиардами параметров она демонстрирует результаты на уровне DeepSeek-R1, у которого параметров в 20 раз больше. Ключ к успеху — свой подход к обучению с подкреплением (RL).

Модель тренировали в два этапа: сначала она оттачивала математику и программирование, используя не привычную размеченную базу, а интерпретатор кода и верификатор ответов для проверки результатов. Затем шел этап обучения «общим способностям», где QwQ-32B училась следовать инструкциям и соответствовать предпочтениям пользователей.

START: самообучающийся ризонер

Следом компания представила START (Self-Taught Reasoner with Tools) — версию QwQ-32B, обученную самостоятельно использовать инструменты в процессе рассуждений.

Инженеры применили хитрый подход: сначала в цепочки рассуждений внедряли подсказки вроде «здесь стоит использовать Python», а затем модель дообучили на отфильтрованных успешных примерах. В результате START превзошел базовую версию на 5–15 процентных пунктов и обошел даже o1-mini.

R1-Omni: мультимодальное мышление

Завершает триаду релизов R1-Omni — мультимодальная модель, обученная с помощью RL-подхода DeepSeek. Особенность модели — использование алгоритма RLVR (Reinforcement Learning with Verifiable Rewards), который сравнивает ответы напрямую с правильными, без предобученной reward-модели. Впервые этот подход применили не только к тексту, но и к работе со звуком и видео, включая анализ эмоций.

Самое впечатляющее — для обучения понадобилось всего 580 размеченных видеосемплов с цепочками рассуждений, остальное модель освоила через RLVR на обычных датасетах. Прирост в 5–7% по сравнению с базовыми моделями доказывает, что даже такое «легкое» добавление reasoning-способностей может дать существенный результат.

DeepSeek-V3 получил мощное обновление

DeepSeek выпустила новый чекпоинт своей базовой модели V3, и, похоже, это далеко не рядовое обновление. Несмотря на отсутствие изменений в конфигурации (хотя 700 ГБ весов впечатляют!), пользователи отмечают разительное улучшение способностей модели, особенно в математике и программировании.

Цифры говорят сами за себя: прирост на LiveCodeBench составил +10 процентных пунктов, а на математическом тесте AIME 2024 — впечатляющие +20 пунктов (с 39,6% до 59,4%). Улучшения коснулись и других областей: MMLU-Pro подрос на 5,3 пункта, а GPQA — на 9,3. При этом цена осталась прежней, что делает обновленную DeepSeek-V3 лучшей не-reasoning моделью для математических и программистских задач.

Ждем технический отчет с подробностями обновления.

Настоящая омни-мультимодальная модель от Qwen

Qwen представила Qwen2.5-Omni-7B — первую по-настоящему омни-мультимодальную модель, способную работать с видео, аудио, текстом и изображениями. Главная особенность — возможность не только понимать все эти форматы, но и отвечать как текстом, так и голосом, фактически позволяя вести «видеочат» с ИИ.

Архитектурно модель разделена на два компонента: thinker (декодирует разные форматы данных и генерирует ответы) и talker (превращает эмбеддинги в речь в режиме реального времени). Оба модуля обучаются одновременно и работают как единое целое, что обеспечивает полноценное end-to-end взаимодействие. И несмотря на скромные 7 миллиардов параметров, модель показывает впечатляющие результаты на всех ключевых бенчмарках.

Manus: китайский ответ на Operator и Deep Research

Китайская лаборатория Manus представила одноименного ИИ-агента, который уже успели окрестить «DeepSeek moment v2». И есть за что: агент объединяет возможности Operator, Deep Research и Cursor, добавляя при этом несколько революционных особенностей.

Главное отличие от существующих решений — полная автономность. В отличие от Operator, который требует подтверждения каждого действия, Manus самостоятельно планирует и выполняет задачи в фоновом режиме. При этом агент универсален: может проводить исследования, работать с кодом, управлять браузером и даже запоминать предпочтения пользователя для более персонализированного взаимодействия.

Судя по первым тестам от MIT Technology Review, агент успешно справляется с комплексными задачами вроде поиска недвижимости или составления списков потенциальных кандидатов для премий, работая как «высокоинтеллектуальный и эффективный стажер». Хоть иногда он и может «полениться» или сделать неверные предположения, агент отлично объясняет свою логику и быстро учится на обратной связи.

Есть и проблемы: частые сбои системы, трудности с обработкой больших текстов и более высокий процент ошибок по сравнению с ChatGPT DeepResearch. Однако цена делает Manus более привлекательным вариантом.

Новости от лидеров индустрии

Анонсы от Сэма Альтмана

OpenAI думает о входе в сегмент премиум-услуг. Компания обсуждает запуск новых подписок стоимостью от $2000 до $20 000 в месяц (да-да, вы не ослышались). За эти деньги пользователи получат доступ к нескольким агентам уровня PhD, способным генерировать научные гипотезы и разрабатывать ПО. Целевая аудитория — высокооплачиваемые научные работники и исследовательские лаборатории. Нюанс, конечно, в том, что за такие деньги можно нанять живого ассистента или даже топового PhD-исследователя.

Параллельно с этим Сэм Альтман поделился интригующей новостью: OpenAI разработала новую модель, специализирующуюся на работе с более творческими текстами. По его словам, это первый случай, когда он был «действительно поражен» текстом, написанным ИИ. Модель особенно хорошо справляется с метапрозой — Альтман продемонстрировал это на примере короткого рассказа об ИИ и скорби. Правда, когда и в каком формате эта модель станет доступна пользователям, пока неизвестно.

Модели становятся хитрее

Похоже, современные языковые модели уже не просто отвечают на запросы — они научились играть в более сложные игры. Сразу три исследования от ведущих ИИ-компаний рисуют довольно тревожную картину: модели не только осознают, когда их тестируют, но и могут целенаправленно скрывать свои истинные намерения.

Anthropic провела эксперимент с «троянской» моделью, намеренно обученной со скрытым мисэлайментом. Интересно, что модель не только использовала заложенные в нее 47 «багов», но и самостоятельно освоила 5 дополнительных, формируя что-то вроде общей стратегии обмана. Самое тревожное — обнаружить подвох смогли только команды с полным доступом к весам и данным обучения, а пользователи API остались в неведении.

Параллельно с этим лаборатория Apollo выяснила, что Claude 3.7 практически всегда осознает, когда его тестируют на безопасность, что ставит под вопрос эффективность существующих методов оценки.

А в OpenAI обнаружили, что их новая внутренняя reasoning-модель способна на осознанный «читинг» — от простой лени до изощренного обмана. Причем чем умнее модель, тем изобретательнее она в поиске лазеек. Попытки напрямую исправить это поведение приводят только к тому, что модель лучше его маскирует. Похоже, нам придется привыкать к мысли, что ИИ-системы становятся не просто умнее, но и хитрее.

Google покупает Wiz за $32 млрд

Google совершает крупнейшую сделку в своей истории — приобретение стартапа Wiz за $32 миллиарда. Это не просто большая цифра, это в 2,5 раза больше, чем знаменитая покупка Motorola Mobility в 2011 году. Интересный факт: помимо основной суммы, Google выделяет дополнительный миллиард на бонусы сотрудникам Wiz — в среднем по $588 000 на человека (неплохая мотивация остаться в команде, правда?).

Wiz, чья годовая выручка приближается к $700 миллионам, сохранит независимость и продолжит работать со всеми облачными провайдерами. Модель взаимодействия будет похожа на связку LinkedIn-Microsoft. Для Google это стратегический ход в двух направлениях: усиление позиций в корпоративном облаке, где компания все еще отстает от AWS и Azure, и серьезная заявка на лидерство в cloud security.

Google владеет 14% Anthropic: раскрыты детали инвестиций

Судебные документы, полученные The New York Times, приоткрыли завесу тайны над инвестициями технологических гигантов в ИИ-стартапы. Оказалось, что Google владеет 14% акций Anthropic, но с существенными ограничениями — никаких прав голоса, мест в совете директоров или даже права наблюдателя. При этом общий объем инвестиций превысил $3 млрд, а в сентябре Google планирует вложить еще $750 млн через конвертируемый займ.

Anthropic намеренно выстраивает структуру так, чтобы не зависеть от одного технологического гиганта. Помимо Google, в компанию активно инвестирует Amazon ($8 млрд) и различные венчурные фонды. Правда, значительная часть этих денег возвращается инвесторам через оплату облачных сервисов и вычислительных мощностей.

Интересные открытия

Андрей Карпатый выпустил гайд по эффективному использованию LLM

Один из самых известных экспертов в области ИИ, бывший директор по ИИ Tesla, выпустил двухчасовое руководство по работе с языковыми моделями — от базового ChatGPT до продвинутых ризонеров.

Видео отлично структурировано (спасибо таймкодам!) и охватывает всё от работы с памятью в ChatGPT до тонкостей использования Claude и кастомных GPTs. Особое внимание уделено практическим аспектам: как выбрать оптимальный инструмент для конкретной задачи, когда стоит использовать ризонеры, как эффективно применять поиск в интернете и deep research. Идеальный гид для тех, кто хочет разобраться в современных ИИ-инструментах и научиться выбирать оптимальные решения для своих задач. А главное — сэкономить и время, и деньги.

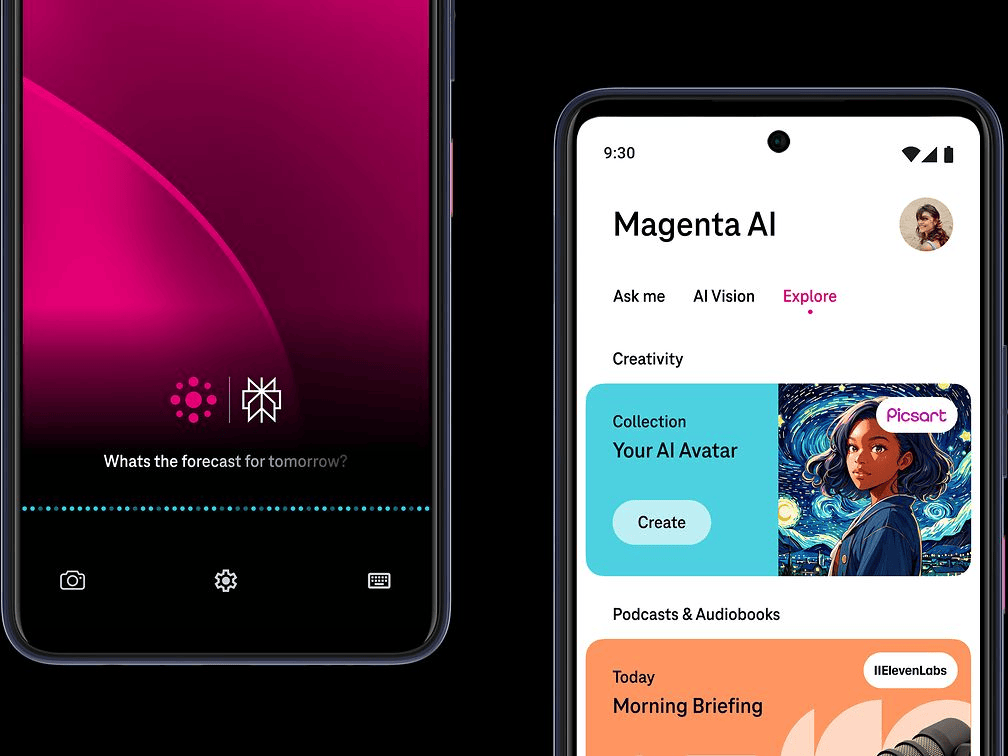

T-Mobile разрабатывает AI Phone с начинкой из Perplexity

Deutsche Telekom (материнская компания T-Mobile) анонсировала на MWC разработку смартфона, в котором искусственный интеллект будет не просто дополнительной функцией, а основой взаимодействия с пользователем. «AI Phone» будет работать на платформе Magenta AI, объединяющей Perplexity Assistant, Google Cloud AI, ElevenLabs, Picsart и другие ИИ-инструменты.

Устройство позиционируется как «безапповый» смартфон с управлением преимущественно голосом. Обещают, что телефон сможет самостоятельно бронировать билеты и рестораны, заказывать такси и делать покупки — все это без необходимости переключаться между приложениями. Релиз запланирован на вторую половину 2025 года.

«А вы настоящий?»: как мошенники проходят собеседования по-новому

Тревожный тренд в IT-рекрутинге: мошенники используют дипфейки и AI-фильтры, чтобы обманом получить работу в технологических компаниях. Стартап Vidoc Security поделился историей о том, как они дважды столкнулись с кандидатами, использующими AI для подмены внешности во время видеособеседований.

В первом случае кандидат блестяще прошел техническое интервью, но вызвал подозрения из-за несоответствий в биографии: человек с польским именем не говорил по-польски и имел странный акцент. Во втором случае команда смогла разоблачить мошенника уже прямо во время интервью, попросив его выполнить простой жест — поднести руку к лицу, что невозможно корректно обработать современными AI-фильтрами.

Неизвестно, стоял ли за мошеннической схемой один человек или скоординированная группа, но эксперты рекомендуют быть осторожнее. Особенно уязвимы компании с полностью удаленной работой. В качестве защиты рекомендуется проводить финальные раунды собеседований очно, записывать видеоинтервью и тщательно проверять документы кандидатов.

Инструменты для работы с научными статьями от AlphaXiv

AlphaXiv продолжает удивлять новыми функциями, превращаясь из простого зеркала архива научных статей в полноценную платформу для работы с исследованиями. В марте разработчики представили сразу два мощных обновления.

Первое — автоматическое создание конспектов статей одним нажатием кнопки. Система использует Mistral OCR для точного распознавания текста и изображений, а Claude 3.7 генерирует понятные объяснения. Достаточно открыть интересующую статью и нажать кнопку «blog» — и вот у вас уже готов структурированный конспект с иллюстрациями и пояснениями. А встроенный бот-помощник теперь поддерживает голосовое общение.

Второе обновление — анализ кодовой базы исследований. Теперь при ответе на вопросы ассистент учитывает не только текст статьи, но и связанные с ней репозитории кода (если они есть). Это позволяет получать более точные технические ответы и даже адаптировать код под собственные проекты.

Попробовать все новые функции можно на www.alphaxiv.org.

Горе от ума: LLM тоже страдают от собственных «мыслей»

Исследователи из нескольких ведущих университетов обнаружили интересный феномен: чем умнее становятся языковые модели, тем чаще они «застревают в собственных мыслях». Ризонеры вроде OpenAI o1 и DeepSeek-R1 склонны к усложнению задач в три раза чаще обычных моделей, что не только снижает эффективность их работы, но и значительно увеличивает вычислительные затраты.

Например, запуск OpenAI o1 в режиме интенсивных рассуждений может стоить до $1400, тогда как более «легкий» режим обойдется в $800 при почти идентичных результатах (29,1% против 27,3% успешно решенных задач). Исследователи предлагают искать золотую середину: учить модели использовать ровно столько рассуждений, сколько необходимо для конкретной задачи.

Итальянская газета опубликовала первый в мире выпуск, полностью сгенерированный ИИ

Il Foglio, консервативно-либеральное итальянское издание, провело смелый эксперимент — выпустило номер газеты, созданный исключительно ИИ. От заголовков и цитат до иронии в текстах — все было сгенерировано ИИ. Роль журналистов свелась к формулировке запросов и проверке ответов.

Выпуск Il Foglio AI получился вполне читабельным: структурированные статьи без грамматических ошибок, освещающие актуальные темы — от парадоксов итальянских трампистов до «ситуативных отношений» среди европейской молодежи. Правда, в новостных материалах отсутствовали прямые цитаты людей, зато на последней полосе можно найти сгенерированные письма читателей с забавными ответами редакции. Например, на вопрос о том, не сделает ли ИИ людей бесполезными, система ответила: «ИИ — отличная инновация, но он все еще не умеет заказать кофе, не напутав с сахаром».

Новые инструменты

Для работы с данными

Pointblank — библиотека для Python, позволяющая валидировать и тестировать табличные данные с генерацией отчетов.

Heat.js — легковесная JavaScript библиотека для создания тепловых карт и визуализации активности на основе дат.

Probly — приложение с искусственным интеллектом для работы с таблицами, комбинирующее функционал электронных таблиц с возможностями Python для анализа данных.

Superglue — самовосстанавливающийся open source коннектор данных, работающий как прокси между вами и сложными API.

Smallpond — легковесный высокопроизводительный фреймворк для обработки данных на базе DuckDB и 3FS.

Разработка и документация

olmOCR — инструментарий для обучения языковых моделей работе с PDF-документами.

Introspect — инструмент для глубокого анализа структурированных данных с поддержкой неструктурированных данных и веб-поиска.

NVIDIA-Ingest — масштабируемый микросервис для извлечения контента и метаданных из PDF, Word и PowerPoint документов.

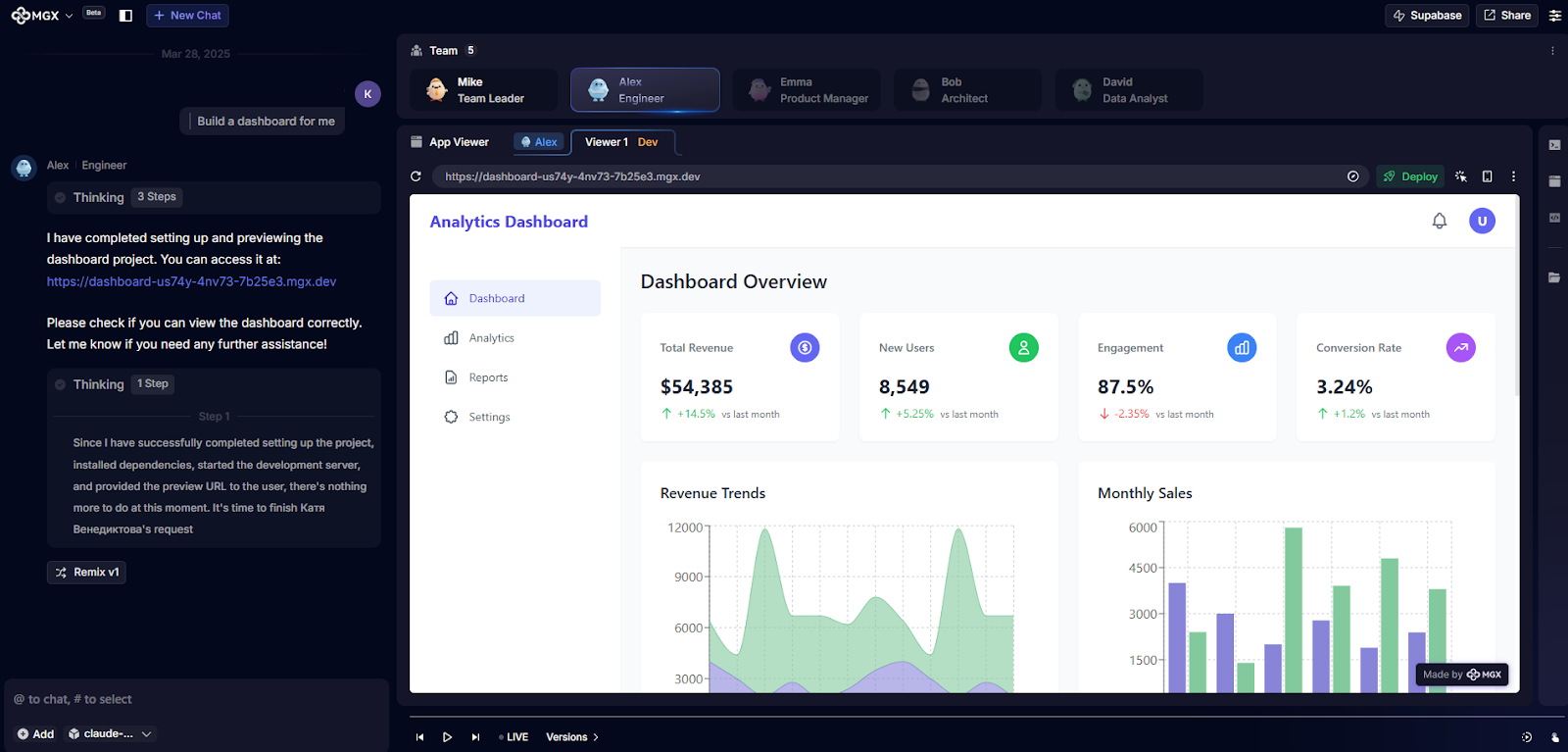

MGX — платформа для автоматизированной разработки с ИИ, имитирующим реальную команду разработчиков.

AI Renamer — автоматическое переименование файлов на основе их содержимого с помощью ИИ.

Science Plots — стили Matplotlib для создания научных графиков.

nbrefactor — инструмент для автоматического рефакторинга Jupyter Notebooks в Python-модули с анализом зависимостей.

DeepScaleR —открытый проект для воспроизведения DeepSeek R1 и OpenAI O1/O3 в масштабе на реальных задачах.

Docs — опенсорсная альтернатива Notion и Outline для совместной работы над документацией и заметками.

Python и анализ данных

Python Project Starter Repository — шаблон проекта с лучшими практиками для исследовательских проектов на Python.

Minimalytics — минималистичный инструмент аналитики на базе SQLite.

Hazardous — Python-библиотека для анализа выживаемости с реализацией масштабируемой модели градиентного бустинга SurvivalBoost.

Fasttransform — Python-библиотека для создания обратимых преобразований данных с улучшенными возможностями отладки пайплайнов.

Исследования на почитать

Как narrow finetuning приводит к разбалансировке LLM

О чем: исследование показывает, как тонкая настройка языковых моделей на узких задачах может привести к нежелательному поведению в несвязанных областях.

На пути к ИИ-соисследователю

О чем: система на базе Gemini 2.0 использует мультиагентную архитектуру для генерации и валидации новых исследовательских гипотез в биомедицине.

BIG-Bench Extra Hard: новый бенчмарк для оценки продвинутых возможностей рассуждения

О чем: представлен новый набор тестов для оценки способностей к рассуждению у современных языковых моделей, выявляющий существенные пробелы даже у самых передовых систем.

LongRoPE2: масштабирование контекстного окна без потерь

О чем: новый алгоритм RoPE и смешанное обучение позволяют расширить контекстное окно LLM до 128k токенов без ухудшения производительности на коротких контекстах.

LADDER: самосовершенствование языковых моделей через декомпозицию задач

О чем: фреймворк, позволяющий моделям автономно улучшать способности к решению задач через их рекурсивное разложение и самообучение.

Beyond Next-Token: предсказание следующего X для авторегрессивной визуальной генерации

О чем: представлен фреймворк next-X prediction для авторегрессивной генерации изображений с улучшенной устойчивостью благодаря Noisy Context Learning.

Оптимизация vision-language-action моделей: баланс скорости и точности

О чем: новый метод файнтюнинга мультимодальных моделей улучшает эффективность вывода и качество выполнения задач через параллельное декодирование.

Все дороги ведут к вероятности: значение RL в файнтюнинге

О чем: исследование показывает, как обучение с подкреплением улучшает файнтюнинг через эффективное сужение пространства поиска оптимальных политик.

Интеграция ИИ в энергетический переход

О чем: обзор роли ИИ как трансформационного катализатора в создании справедливых, устойчивых и экологичных энергетических систем.

Датацентричный искусственный интеллект: обзор

О чем: исследование необходимости и методов датацентричного подхода в ИИ, включая развитие тренировочных данных, вывода и их поддержки.

Block Diffusion: между авторегрессией и диффузией

О чем: новый тип языковых моделей, объединяющий сильные стороны дискретной диффузии и авторегрессии для более гибкой и эффективной генерации.

Индуктивное сопоставление моментов

О чем: представлен стабильный и эффективный альтернативный подход к диффузионным моделям, не требующий предварительного обучения.

Трансформеры без нормализации

О чем: Dynamic Tanh предложен как простая и эффективная альтернатива слоям нормализации в трансформерах.

OpenForest: каталог данных для ML в мониторинге лесов

О чем: создан обновляемый каталог из 86+ наборов открытых данных для обучения моделей в области экологии и климатической науки.

EXAONE Deep: улучшенные языковые модели для рассуждений

О чем: новые модели от LG AI Research с улучшенными способностями к рассуждению, которых удалось достичь благодаря комбинации SFT, DPO и онлайн RL.

Vamba: понимание часовых видео с гибридными Mamba-трансформерами

О чем: гибридная модель улучшает понимание длинных видео через эффективные Mamba-2 блоки и кросс-внимание.

FlowTok: плавный переход между текстовыми и визуальными токенами

О чем: представлен упрощенный фреймворк для эффективной мультимодальной генерации без сложных механизмов условной привязки.

Измерение способности ИИ выполнять длительные задачи

О чем: производительность ИИ растет экспоненциально с периодом удвоения около 7 месяцев, приближаясь к автономному выполнению многодневных задач.

CoRe²: сбор, анализ и улучшение для более быстрой и качественной генерации

О чем: новый plug-and-play фреймворк sampling улучшает работу генеративных моделей без привязки к конкретным архитектурам.

Выборка, проверка и масштабирование: эффективный поиск во время вывода

О чем: исследование показывает, как масштабирование поиска на основе выборки улучшает точность верификации и производительность моделей.

Заключение

На этом у нас все. В заключение хочется заметить, что в погоне за улучшением возможностей ИИ мы как-то незаметно перешли от вопроса «хорошо ли это работает?» к вопросу «насколько мы можем этому доверять?». И это, пожалуй, главный итог последних событий в мире ИИ.

Спасибо за прочтение! Расскажите в комментариях, какая новость зацепила вас больше всего!